Послушай краткое содержание поста:

Мой сайт похож на ухоженный сад, где каждый посетитель наполняет его новым контентом. Но с появлением крутых инструментов искусственного интеллекта, которые умеют выкачивать данные с сайтов, я понял, что нужно усилить защиту, чтобы не допустить этого. Благодаря своему опыту я собрал Как защитить свой сайт от скрапинга с помощью искусственного интеллекта. Давайте пройдемся по нескольким шагам, чтобы защитить твой сайт. Я расскажу, как использовать директивы robots.txt, настроить CAPTCHA и другие методы, чтобы твой контент оставался только на твоем домене. Главное — сохранить целостность твоего онлайн-пространства и убедиться, что только люди получают пользу от твоего труда.

In the spirit of keeping your digital haven safe, remember, “A sturdy gate ensures that only the welcome can appreciate the garden within.”

Основные выводы

Защита моего сайта от скрейперов с искусственным интеллектом — это постоянная борьба, которая требует внимания и активных стратегий. Я обнаружил, что эффективная настройка файла robots.txt, установка CAPTCHA, выявление и блокировка известных скрейперов с искусственным интеллектом инструменты, Контроль доступа к моему контенту и регулярное обновление протоколов безопасности — это важные стратегии. Добавление юридических мер защиты — это еще один уровень защиты, но быть начеку и следить за техническими новостями — лучший способ обеспечить безопасность моего контента и сохранить ценность моего сайта для посетителей.

Не забывай обновлять защиту своего сайта, потому что методы сбора данных постоянно развиваются. Регулярно проверяй настройки безопасности и будь готов к новым вызовам, чтобы защитить свой контент.

Понимание веб-парсинга с помощью искусственного интеллекта

Когда мы говорим о веб-парсинге с помощью ИИ, важно понимать, какие этические вопросы это поднимает. Я расскажу о возможных рисках и преимуществах, чтобы мы могли создать основу для этического поведения при сборе данных с помощью ИИ. Потом я расскажу о технических мерах, которые могут использовать владельцы сайтов, чтобы защитить свой контент от несанкционированного парсинга с помощью ИИ.

Когда мы говорим о веб-парсинге с помощью ИИ, важно понимать, какие этические вопросы это поднимает. Я расскажу о возможных рисках и преимуществах, чтобы мы могли создать основу для этического поведения при сборе данных с помощью ИИ. Потом я расскажу о технических мерах, которые могут использовать владельцы сайтов, чтобы защитить свой контент от несанкционированного парсинга с помощью ИИ.

Скребковые этические проблемы

Понимание этических аспектов ИИ Скраппинг содержимого

Почему стоит беспокоиться об этике использования инструментов искусственного интеллекта для извлечения контента с вашего сайта? Когда мы говорим об этом, важно помнить о сложностях, связанных с конфиденциальностью данных. Нерегулируемый скрейпинг ИИ может привести к несанкционированному сбору конфиденциальной информации, что может нарушить интеллектуальную собственность тех, кто создает контент. Также важно соблюдать законы, которые регулируют сбор и использование данных. Эти законы направлены на защиту людей и компаний от нарушений конфиденциальности и неправомерного использования их информации. Быть в курсе этих правил необходимо для обеспечения безопасности контента вашего сайта и этичности ваших действий по мере развития технологий.

Как справиться со скрейпингом

Чтобы автоматические системы не собирали данные с моего сайта, я регулярно обновляю файл robots.txt. Это позволяет мне определять, какие части сайта доступны для ботов, типа GPTBot. Постоянно обновляя эти настройки, я защищаю контент своего сайта от несанкционированного извлечения с помощью автоматических инструментов.

При этом я не просто следую технической процедуре; я защищаю ценность и конфиденциальность информации, которую я с таким трудом создал. Как веб-мастера, мы должны быть бдительными и проактивными, чтобы защитить наши цифровые ресурсы, которым доверяют пользователи — это важный запретный путь.

Помни, что хорошо настроенный файл robots.txt — это простой, но эффективный способ защиты от назойливых попыток скраперов.

Регулярно обновляй файл Robots.txt

Чтобы ваш сайт был в безопасности, нужно регулярно проверять и обновлять файл robots.txt. Вот как я это делаю:

- Установите регулярный график обновлений.

- Используй самые крутые методы, чтобы определить, к каким частям твоего сайта могут заходить пользовательские агенты (типа веб-краулеров).

- Следи за последними новостями в области инструментов для сбора данных с помощью искусственного интеллекта, чтобы быть в курсе возможных рисков безопасности.

- Сделай нужные изменения в запретных путях, чтобы твой контент был защищен от посторонних.

Зачем обновлять файл robots.txt?

Обновление файла robots.txt — это простой, но эффективный способ защитить свой сайт. Он сообщает поисковым системам и другим веб-краулерам, к каким страницам или разделам вашего сайта не следует обращаться или индексируемый. Это может помочь избежать нежелательного копирования и стать частью более широкой стратегии защиты контента твоего сайта.

Помни, что с появлением новых типов веб-краулеров нужно быть начеку и обновлять файл robots.txt. Хорошо настроенный файл robots.txt — это важная часть общей безопасности твоего сайта.

Как правильно использовать файл Robots.txt

To protect your website from unwanted automated data collection, let's discuss how to update the robots.txt file carefully. You can instruct certain web crawlers, such as OpenAI's GPTBot, to either access or bypass your site content by creating specific user-agent rules. By setting up these parameters with attention to detail, you gain precise control over which parts of your site can be индексируемый or ignored by different AI systems.

To protect your website from unwanted automated data collection, let's discuss how to update the robots.txt file carefully. You can instruct certain web crawlers, such as OpenAI's GPTBot, to either access or bypass your site content by creating specific user-agent rules. By setting up these parameters with attention to detail, you gain precise control over which parts of your site can be индексируемый or ignored by different AI systems.

Правильно отредактируй файл Robots.Txt

Чтобы защитить свой сайт от нежелательного скрапинга с помощью искусственного интеллекта, важно внимательно следить за файлом robots.txt. Этот шаг очень важен для сохранения конфиденциальности данных вашего сайта и соблюдения законов о сборе данных. Вот мой гид, как это сделать эффективно:

- Найди файлСначала я зашел на сервер своего сайта и нашел файл robots.txt, который уже был там.

- Просмотрите действующие правила: Затем я внимательно изучаю файл, чтобы полностью понять существующие правила и их значение для моего сайта.

- Обновляй с осторожностью: With attention to detail, I adjust or insert new rules to specify what AI systems can and can't do, using ‘Disallow:' to block and ‘Allow:' to give access.

- Проверь измененияПосле того, как я внесу изменения, я запускаю обновленный файл robots.txt через тестеры, чтобы убедиться, что правила написаны правильно и работают как надо.

Внимательно выполняя эти шаги, я обновляю файл robots.txt, чтобы мой сайт был в безопасности, но при этом оставался открытым для всех. поисковые системы которые помогают людям находить мой контент.

Внедрение проверки CAPTCHA

Если говорить о проверке CAPTCHA, то этот способ — отличный способ защиты от автоматического сбора данных без разрешения. Он работает, отличая настоящую человеческую деятельность от автоматизированное программное обеспечение, эффективно блокируя нежелательных ботов и пропуская настоящих пользователей. Но когда используешь CAPTCHA, важно подумать, как это может повлиять на взаимодействие с пользователями. Найти правильный баланс — это ключ к тому, чтобы твой сайт оставался удобным для пользователей.

Эффективность CAPTCHA

Включение проверки CAPTCHA — это надежный способ защитить мой сайт от несанкционированного доступа. Сокращение контента с помощью автоматических инструментов. Вот почему я считаю, что это крутая идея:

- Сложные задачи: Изысканный CAPTCHA — это сложные головоломки, которые трудно решить автоматически. системы, но все равно понятные для людей.

- Постоянные обновления: Часто обновляя алгоритмы CAPTCHA, они могут опередить развитие искусственного интеллекта, который в противном случае мог бы обойти неизменные системы.

- Многоуровневая безопасностьКогда CAPTCHA используется вместе с другими мерами безопасности, она создает надежный барьер против несанкционированного доступа.

- Бдительность: Проверка, как работает CAPTCHA и насколько она эффективна, может показать, когда нужно что-то поменять или улучшить.

Хотя CAPTCHA делает сайт более безопасным, я всегда думаю об этике и стараюсь, чтобы это как можно меньше влияло на пользователей. Найти баланс между надежной безопасностью и удобством для пользователей — это сложная и постоянная задача.

Влияние на пользовательский опыт

Внедряя проверки CAPTCHA, я понимаю, что они иногда могут раздражать пользователей, даже если они хорошо справляются с ботами, которые копируют контент с помощью искусственного интеллекта. По моим оценкам, CAPTCHA эффективно сдерживают этих ботов, что помогает управлять потоком посетителей сайта и снижает вероятность несанкционированного копирования контента. Тем не менее, важно использовать этот инструмент с умом, чтобы не отпугнуть людей, которые заходят на ваш сайт. Главное — найти правильный баланс между обеспечением легкого доступа к контенту и его защитой от нежелательного сбора с помощью искусственного интеллекта. Слишком много тестов CAPTCHA могут отпугнуть столько же реальных пользователей, сколько и ботов. Я использую CAPTCHA в тех областях, где сбор контента наиболее вероятен, при этом остальная часть сайта остается удобной для пользователей. Моя цель — обеспечить посетителям сайта отличный опыт, одновременно защищая контент сайта от любого несанкционированного сбора с помощью искусственного интеллекта.

Блокировка определенных роботов-пауков искусственного интеллекта

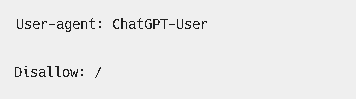

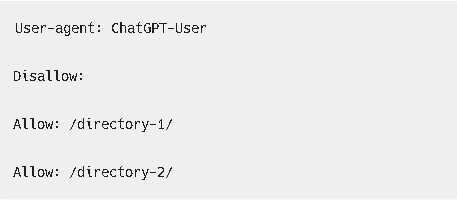

Как человек, который управляет сайтом, я могу заблокировать некоторые ИИ-краулеры, такие как GPTBot от OpenAI, чтобы они не копировали контент с моего сайта. Это не только помогает предотвратить несанкционированный сбор моего контента, но и показывает уважение к этическим нормам и правилам использования контента. Вот как я это делаю:

- Изменить

файл robots.txtЯ настраиваю этот файл с конкретными инструкциями для роботов-пауков, где объясняю, какие части моего сайта им нельзя просматривать.

Пользовательский агент: GPTBot

Запретить: /

Пользовательский агент: ChatGPT-User

Запретить: /

Пользовательский агент: CCBot

Запретить: /

- Проверь журналы сервераЯ регулярно проверяю логи своего сервера, чтобы заметить любую подозрительную активность AI-краулеров.

- Настройка CAPTCHAНа тех частях моего сайта, где люди общаются, я использую CAPTCHA. Эти тесты отлично помогают отличить настоящих людей от ботов.

- Блокировка определенных IP-адресовКогда нужно, я блокирую IP-адреса, которые, как я знаю, связаны с AI-краулерами, чтобы они не забирались на мой сайт.

Делая это, я защищаю свой контент и слежу за тем, чтобы соблюдать правила, связанные с конфиденциальностью данных и интеллектуальной собственностью.

Как управлять доступностью контента

Защита контента твоего сайта от несанкционированного копирования

Чтобы решить проблему копирования контента, давайте поговорим о том, как контролировать, кто может заходить на ваш сайт. Очень важно не пускать ботов, и я расскажу, как не дать этим системам копировать или Индексирование материалы твоего сайта. Это потребует технических изменений и тщательной настройки мер контроля доступа.

Защита контента твоего сайта

Для тех, кто управляет сайтом, важно, чтобы контент оставался эксклюзивным и защищенным от автоматических систем сбора информации. Внедрение определенных технических мер может помочь тебе контролировать, кто имеет доступ к сайту и индекс содержимое твоего сайта.

Ты можешь подумать о том, чтобы настроить файл robots.txt. файл для указания поисковой системе ботам, какие части твоего сайта недоступны. Использование CAPTCHA-систем тоже может отпугнуть ботов, не мешая при этом людям. Если хочешь более сложный подход, можно использовать серверные проверки, чтобы отличать настоящих посетителей от потенциальных скраперов.

Помни, что целостность и эксклюзивность твоего контента — это самое главное. Если ты будешь принимать меры для защиты своего сайта, ты сможешь контролировать свой контент и его распространение. В конце концов, контент, который ты создаешь, — это отражение твоего бренда, и его нужно бережно охранять.

Ограничение доступа ботов

Ограничение доступа ботов

Я понял, что если сделать определённые шаги, то можно значительно снизить риск того, что автоматические системы будут собирать контент с моего сайта. Вот как я это делаю:

- Настройка файла Robots.txt: Я дорабатываю свой

файл robots.txtфайл для управления доступом ботов, не забывая про юридические моменты скрапинга и вопросы конфиденциальности данных. - Введение ограничений скорости: Введя ограничения скорости на моем сервере, я могу уменьшить возможные проблемы, связанные с ботовым трафиком.

- Как использовать API-контрольЯ делюсь как можно меньше инфой через API и требую правильную аутентификацию, чтобы ограничить доступ.

- Использование сетей доставки контентаИспользование CDN с функциями управления ботами позволяет мне контролировать, кто получает доступ к моему контенту, и эффективно его защищать.

Эти меры создают надежную защиту от несанкционированного сбора контента с помощью автоматических инструментов.

Предотвращение копирования контента

После обновления моего файл robots.txt файл, я сейчас сосредоточен на мерах по предотвращению скрапинга контента, чтобы мой сайт оставался доступным, но при этом безопасным. Я изучаю технические аспекты скрапинга, его правовые последствия и важность защиты данных пользователей от сложных методов скрапинга с использованием искусственного интеллекта.

| Стратегия | Описание |

|---|---|

| Доставка переменного контента | Показывайте автоматизированным инструментам другой контент, чем людям. |

| Мониторинг того, что делают пользователи | Проверь, нет ли каких-то действий, которые могут быть связаны со скрапингом. |

| Ограничения доступа | Управляйте, как часто пользователи могут заходить на сайт, и блокируйте подозрительные IP-адреса. |

Внимательно внедряя эти стратегии, я не только защищаю контент своего сайта, но и обеспечиваю конфиденциальность и безопасность информации пользователей. Это продуманный план по управлению контентом моего сайта и предотвращению несанкционированного доступа или злоупотребления со стороны автоматизированных инструментов.

Использование этих стратегий — это умный способ опередить тех, кто может попытаться воспользоваться твоим трудом. Это как установить крутую систему сигнализации, которая не только следит за злоумышленниками, но и уважает конфиденциальность твоих гостей. Речь идет о том, чтобы действовать на упреждение, а не реагировать на потенциальные угрозы.

Регулярно обновляй меры безопасности

Настройка базовой защиты, типа изменения файла robots.txt или добавления CAPTCHA, — это хорошее начало, но чтобы действительно защититься от продвинутых AI-инструментов, которые копируют контент, нужно постоянно обновлять стратегии безопасности твоего сайта. Технологическая среда постоянно меняется, возможности AI становятся все более сложными и иногда обходят старые методы безопасности. Поэтому для поддержания безопасности твоего сайта нужен стратегический, технически грамотный и систематический подход.

Вот моя идея:

- Регулярные проверки безопасностиЯ стараюсь регулярно проверять безопасность, чтобы заметить слабые места, и следить за тем, чтобы мои меры безопасности были актуальными и эффективными.

- Будьте в курсе обновленийЯ слежу за новыми обновлениями безопасности и проверяю, чтобы всё программное обеспечение на моём сайте было обновлённым.

- Как настроить меры безопасностиЯ настраиваю свои параметры безопасности, чтобы справиться с конкретными угрозами, что помогает сохранить баланс между защитой контента и обеспечением его доступности по нужным причинам.

- Анализ трафика и отчетность: Следя за тем, как люди заходят на мой сайт, и внимательно изучая журналы доступа, я могу быстро заметить и отреагировать на подозрительные действия, которые могут быть связаны с попыткой сбора данных искусственным интеллектом.

Обеспечение безопасности моего сайта — это не что-то, что можно настроить раз и забыть; это постоянная борьба с теми, кто хочет навредить. Будучи начеку и заботясь о безопасности, я защищаю не только контент своего сайта, но и конфиденциальность тех, кто его посещает.

Рассмотрение правовых мер защиты

Разбираясь в юридических тонкостях, я изучаю законы и правила об авторском праве, чтобы защитить свой сайт от несанкционированного сбора данных искусственным интеллектом. Важно подойти к этому вопросу систематически, чтобы понять, как национальные и международные законы об авторском праве влияют на материалы на моем сайте. Я также ознакомился с Законом о защите авторских прав в цифровую эпоху (DMCA), чтобы понять, как он может защитить мой контент от нарушений, связанных с искусственным интеллектом.

Проверка условий использования инструментов искусственного интеллекта — это важный шаг, чтобы они не перегибали палку с правами на использование и сбор данных с сайтов. Такое внимание к деталям — ключ к сохранению удобства пользования моим сайтом и предотвращению неправомерного использования моего контента, что может снизить влияние моего бренда и уменьшить вовлеченность посетителей.

Кроме того, я думаю о технических штуках, типа введения строгого контроля доступа и постоянного анализа трафика, чтобы выявлять и сдерживать попытки скрапинга. Я планирую использовать и юридические меры, и технические защиты, чтобы сохранить уникальность своего сайта и защитить творческие усилия, которые за ним стоят.

Часто задаваемые вопросы

Если я заблокирую AI-инструменты от сканирования моего сайта, повлияет ли это на видимость или рейтинг моего сайта в других поисковых системах, таких как Google или Bing?

Я думаю, может ли запрет на сканирование моего сайта инструментами искусственного интеллекта повлиять на его эффективность в поисковые системы, такие как Google или Bing. Важно прояснить все недоразумения по поводу видимости в Интернете; эти Поисковые системы используют свои алгоритмы для ранжирования сайтов.. Они не зависят только от Индексирование с помощью инструментов искусственного интеллекта. Я хочу, чтобы мой контент был защищен и при этом оставался на хорошей позиции в результаты поиска. На деле это значит найти правильный баланс между защитой моих содержание сайта и хорошее SEO результаты.

Как отличить настоящие поисковые роботы от искусственных, когда смотришь на трафик своего сайта?

Чтобы отличить нормальные поисковые роботы от тех, кто без разрешения копирует контент, когда смотрю на мой сайт, трафик сайта, Я внимательно смотрю на поведение пользователей, которое может быть связано с автоматизированными действиями. Чтобы не пускать потенциально опасный трафик, я использую методы блокировки IP-адресов. Еще я пользуюсь инструментами для обнаружения ботов, которые помогают мне находить и контролировать нежелательных ботов. Эти меры помогают мне защищать свой контент и при этом делать сайт доступным для нормальных пользователей. поисковые системы.

Понимание разницы между настоящим и искусственным трафиком помогает мне следить за тем, чтобы аналитика моего сайта была точной, а контент не попал в чужие руки. Как владелец сайта, я должен заботиться о безопасности своей цифровой собственности, как будто это обычный магазин, который нужно защищать от воров. С помощью этих стратегий я могу спокойно управлять трафиком своего сайта и следить за его целостностью.

Что делать, если заметил, что твой контент уже скопили с помощью ИИ-инструмента без твоего разрешения?

Когда я заметил, что мой контент использовали без моего разрешения с помощью какого-то ИИ-инструмента, первым делом тщательно запишу все случаи такого нарушения. Потом я бы попытался вернуть свой контент, связавшись с ответственной стороной или, если понадобится, отправив запрос на удаление по DMCA. Если это не поможет, можно подумать о судебном иске. Кроме того, стоит рассказать всем о несанкционированном использовании моей работы, чтобы люди использовали инструменты искусственного интеллекта правильно. Бдительность и быстрое реагирование — это ключ к защите своих авторских прав в Интернете.

Помни: защита твоих творческих работ — это не только право, но и обязанность.

Есть ли какие-то стандарты или лучшие практики, чтобы поставить водяной знак на мой контент, чтобы показать, что его нельзя использовать для обучения моделей искусственного интеллекта?

Сейчас я изучаю, как защитить свой контент от того, чтобы его без разрешения использовали для обучения моделей искусственного интеллекта. Один из способов — использовать цифровые водяные знаки и отпечатки контента, которые вставляют невидимые метки или уникальные коды в мои работы. В сочетании с четкими правилами использования эти стратегии служат сигналом, что мои материалы не должны использоваться для обучения моделей ИИ. Сообщество все еще работает над общими рекомендациями по этому вопросу, поэтому я слежу за последними стратегиями, чтобы обеспечить надлежащую защиту своих работ.

“Protecting intellectual property in an age where data is constantly fed into algorithms is a shared concern for creators. It's wise to be proactive and informed.”

Если инструменты искусственного интеллекта научатся обходить CAPTCHA, мне придется применять более сложные стратегии безопасности, чтобы защитить свой сайт от несанкционированного извлечения данных. Один из эффективных способов — это Поведенческая биометрия, который следит за странными вещами в том, как люди взаимодействуют с сайтом. Это может помочь отличить настоящих людей от потенциальных автоматических скрейперов.

Еще один уровень защиты включает в себя Анализ отпечатков пальцев. Эта технология анализирует уникальные характеристики устройства и браузера, такие как операционная система, разрешение экрана и установленные шрифты, чтобы выявить несоответствия, которые обычно характерны для ботов.

Чтобы быть на шаг впереди, я бы сделал следующее: Адаптивные вызовы. Это проверки безопасности, которые могут быть разными по сложности в зависимости от оцененного риска, обеспечивая динамическую защиту, которая подстраивается под уровень обнаруженной угрозы. Используя эти продвинутые методы, я могу значительно усилить безопасность своего сайта от новейших инструментов для сбора данных, основанных на искусственном интеллекте.

Что такое защита от скрапинга с помощью искусственного интеллекта в контексте Всемирной паутины?

Защита от скрапинга с помощью ИИ — это методы и технологии, которые используются, чтобы боты не могли без разрешения собирать или скрапировать данные с сайтов. Эти технологии используют возможности искусственного интеллекта, чтобы обнаруживать, идентифицировать и блокировать такие действия.

Почему скрейперы с искусственным интеллектом — это проблема для интеллектуальной собственности в интернете?

AI-скребки — это проблема, потому что они могут быстро и эффективно собирать кучу конфиденциальной информации, которая есть в сети. Эти данные могут включать в себя защищенный авторским правом контент, коммерческие тайны, базы данных или другие цифровые активы, которые предназначены только для использования на исходном веб-сайте.

Как работает скребок искусственного интеллекта?

AI-скребок имитирует, как люди просматривают сайты. Он заходит на страницы, находит нужную инфу по заданным параметрам, а потом копирует эти данные, чтобы использовать их где-то еще. Эти инструменты могут быть разные: некоторые умеют лазать по сложным сайтам и обходить базовые меры защиты от скрейпинга.

Какие методы обычно используются для защиты от скрапинга с помощью искусственного интеллекта?

Техники, которые часто используют для защиты от скрапинга с помощью ИИ, включают ограничение скорости (ограничение количества запросов, которые IP-адрес может сделать за определенный период времени), тесты CAPTCHA (которые требуют от пользователей доказать, что они люди), анализ пользовательских агентов (для выявления подозрительной активности браузера) и более продвинутые алгоритмы машинного обучения, которые могут обнаруживать необычные паттерны, указывающие на поведение ботов.

Можно ли использовать искусственный интеллект для защиты от веб-скрейпинга?

Да, можно использовать разные виды искусственного интеллекта, типа алгоритмов машинного обучения, чтобы обнаруживать и предотвращать веб-скрейпинг. Эти системы учатся на предыдущих примерах поведения ботов, что позволяет им лучше предвидеть и предотвратить возможные будущие атаки. Они также могут использовать методы обнаружения в реальном времени, которые позволяют сразу же реагировать, когда подозрительная активность ботов происходит.

Мои последние мысли о том, как защитить твой сайт от скрапинга с помощью инструментов искусственного интеллекта

Защита моего сайта от нежелательного скрапинга с помощью ИИ — это постоянная работа, которая требует внимательности. Я понял, что умное использование robots.txt, внедрение CAPTCHA, блокировка известных ИИ-скреперов, управление доступом к контенту и постоянное обновление мер безопасности — это важные шаги. Хотя добавление юридических мер дает дополнительную защиту, оставаться бдительным и технически подкованным — это ключ к тому, чтобы мой контент оставался в моей компетенции, сохраняя целостность моего сайта и ценность, которую он предлагает тем, кто его посещает.

Авторитетные ссылки

Если хочешь узнать больше о том, как защитить свои сайты от AI-краулеров, то я рекомендую тебе заглянуть в следующий пост:

- ITPro – AI web scraping: How to protect your business from

- В этой статье рассказывается о сложностях веб-парсинга с помощью ИИ и связанных с ним рисках. Здесь объясняется, как ИИ может быстрее и лучше собирать данные, а потом их анализировать, чтобы получить нужные результаты.

- Статья ITPro

- The Authors Guild – Practical Tips for Authors to Protect Their Works from AI Use

- Этот ресурс предлагает практические советы для авторов и владельцев веб-сайтов о том, как защитить свои работы от использования искусственного интеллекта, в том числе с помощью файла robots.txt для блокировки веб-краулеров искусственного интеллекта, таких как GPTBot от OpenAI.

- Советы от Гильдии авторов

- Resolution Digital – Protect Website from Содержание ИИ Скребковые работы

- В этой статье рассказывается, как защитить свой сайт от скрапинга и несанкционированного использования такими AI-инструментами, как ChatGPT. Здесь обсуждается использование файлов robots.txt, внедрение CAPTCHA и блокировка диапазонов IP-адресов.

- Цифровое руководство по разрешению

- Octoparse – Web Scraping for Brand Protection and Cybersecurity

- Это блог В этой статье рассказывается, как можно использовать веб-парсинг для защиты бренда и кибербезопасности. Здесь обсуждается, как с помощью инструментов веб-парсинга можно найти потенциальные нарушения авторских прав.

- Статья Octoparse

- ScienceDirect – The war against AI web scraping

- В этой статье из ScienceDirect рассказывается о растущем недовольстве веб-парсингом с помощью ИИ, а также о том, как быстро развивается ИИ и как его обучают на огромных наборах данных с текстом и другим цифровым контентом.

- Статья ScienceDirect