ฟังสรุปโพสต์:

เว็บไซต์ของฉันเปรียบเสมือนสวนที่ได้รับการดูแลอย่างดี มีเนื้อหาต้นฉบับที่เติบโตอย่างงดงามในทุกครั้งที่ผู้เยี่ยมชมเข้ามา อย่างไรก็ตาม ด้วยความก้าวหน้าของเครื่องมือ AI ที่มีความสามารถในการดึงข้อมูลจากเว็บไซต์ ฉันจึงตระหนักถึงความจำเป็นในการเสริมสร้างระบบป้องกันของเว็บไซต์เพื่อป้องกันการดึงข้อมูลที่ไม่พึงประสงค์เหล่านี้ จากประสบการณ์ของฉัน ฉันได้รวบรวม กลยุทธ์ในการปกป้องเว็บไซต์ของคุณจากการขูดข้อมูลด้วย AI อย่างมีประสิทธิภาพ. มาดูขั้นตอนในการปกป้องเว็บไซต์ของคุณกัน ฉันจะแนะนำคุณในการใช้คำสั่ง robots.txt การตั้งค่า CAPTCHA และการใช้วิธีเพิ่มเติมเพื่อให้แน่ใจว่าเนื้อหาของคุณจะอยู่บนโดเมนของคุณเท่านั้น ทั้งหมดนี้เกี่ยวกับการรักษาความศักดิ์สิทธิ์ของอาณาจักรออนไลน์ของคุณ เพื่อให้แน่ใจว่าผู้เยี่ยมชมที่เป็นมนุษย์เท่านั้นที่จะได้รับประโยชน์จากผลงานอันหนักหน่วงของคุณ.

ในจิตวิญญาณของการรักษาที่หลบภัยดิจิทัลของคุณให้ปลอดภัย จงจำไว้ว่า “ประตูที่แข็งแรงทำให้แน่ใจว่าเฉพาะผู้ที่ได้รับการต้อนรับเท่านั้นที่จะชื่นชมสวนภายใน”

ประเด็นสำคัญ

การปกป้องเว็บไซต์ของฉันจากโปรแกรมรวบรวมข้อมูล AI เป็นภารกิจที่ต้องทำอย่างต่อเนื่องซึ่งต้องการความใส่ใจและกลยุทธ์เชิงรุก ฉันพบว่าการกำหนดค่าไฟล์ robots.txt อย่างมีประสิทธิภาพ การตั้งค่า CAPTCHA การระบุและบล็อกโปรแกรมรวบรวมข้อมูล AI ที่รู้จัก เครื่องมือ, การควบคุมว่าใครสามารถเข้าถึงเนื้อหาของฉันได้ และการปรับปรุงโปรโตคอลความปลอดภัยอย่างสม่ำเสมอ เป็นกลยุทธ์ที่สำคัญอย่างยิ่ง การเพิ่มการคุ้มครองทางกฎหมายเป็นการเพิ่มชั้นการป้องกันอีกชั้นหนึ่ง แต่การรักษาความระมัดระวังและมีความรู้ทางเทคนิคที่ดีอยู่เสมอ คือวิธีที่ดีที่สุดในการรักษาความปลอดภัยของเนื้อหาของฉัน และรักษาคุณค่าของเว็บไซต์ของฉันไว้สำหรับผู้เยี่ยมชม.

อย่าลืมอัปเดตการป้องกันของเว็บไซต์ของคุณให้ทันสมัยอยู่เสมอ เนื่องจากวิธีการขุดข้อมูลกำลังพัฒนาอย่างต่อเนื่อง ตรวจสอบการตั้งค่าความปลอดภัยของคุณเป็นประจำ และเตรียมพร้อมที่จะปรับตัวให้เข้ากับความท้าทายใหม่ ๆ เพื่อปกป้องเนื้อหาของคุณให้ปลอดภัย.

การทำความเข้าใจการดึงข้อมูลจากเว็บไซต์ด้วยปัญญาประดิษฐ์

เมื่อเราเข้าใกล้หัวข้อเกี่ยวกับการดึงข้อมูลจากเว็บไซต์ด้วยปัญญาประดิษฐ์ (AI web scraping) สิ่งสำคัญคือการตระหนักถึงผลกระทบทางจริยธรรมของการปฏิบัตินี้ ผมจะประเมินความเสี่ยงและประโยชน์ที่อาจเกิดขึ้น โดยทำให้แน่ใจว่าเราได้สร้างกรอบการทำงานสำหรับการปฏิบัติที่มีจริยธรรมในการรวบรวมข้อมูลด้วย AI หลังจากนั้น ผมจะสำรวจมาตรการทางเทคนิคที่เจ้าของเว็บไซต์สามารถใช้เพื่อปกป้องเนื้อหาของตนจากการดึงข้อมูลโดย AI ที่ไม่ได้รับอนุญาต.

เมื่อเราเข้าใกล้หัวข้อเกี่ยวกับการดึงข้อมูลจากเว็บไซต์ด้วยปัญญาประดิษฐ์ (AI web scraping) สิ่งสำคัญคือการตระหนักถึงผลกระทบทางจริยธรรมของการปฏิบัตินี้ ผมจะประเมินความเสี่ยงและประโยชน์ที่อาจเกิดขึ้น โดยทำให้แน่ใจว่าเราได้สร้างกรอบการทำงานสำหรับการปฏิบัติที่มีจริยธรรมในการรวบรวมข้อมูลด้วย AI หลังจากนั้น ผมจะสำรวจมาตรการทางเทคนิคที่เจ้าของเว็บไซต์สามารถใช้เพื่อปกป้องเนื้อหาของตนจากการดึงข้อมูลโดย AI ที่ไม่ได้รับอนุญาต.

ข้อกังวลทางจริยธรรมในการดึงข้อมูล

การเข้าใจมิติทางจริยธรรมของปัญญาประดิษฐ์ การขูดเนื้อหา

ทำไมคุณควรให้ความสำคัญกับแง่มุมทางจริยธรรมของเครื่องมือ AI ที่ดึงเนื้อหาจากเว็บไซต์ของคุณ? เมื่อพิจารณาหัวข้อนี้ จำเป็นต้องพิจารณาความซับซ้อนของความเป็นส่วนตัวของข้อมูล การดึงข้อมูลจาก AI ที่ไม่มีการควบคุมอาจนำไปสู่การรวบรวมข้อมูลที่เป็นกรรมสิทธิ์โดยไม่ได้รับอนุญาต ซึ่งอาจละเมิดทรัพย์สินทางปัญญาของผู้ที่สร้างเนื้อหาได้ นอกจากนี้ยังมีความสำคัญที่จะต้องปฏิบัติตามกฎหมายที่ควบคุมวิธีการรวบรวมและใช้ข้อมูล กฎหมายเหล่านี้มีวัตถุประสงค์เพื่อปกป้องบุคคลและบริษัทจากการละเมิดความเป็นส่วนตัวและการใช้ข้อมูลของพวกเขาในทางที่ผิด การติดตามข้อมูลให้ทันสมัยกับกฎระเบียบเหล่านี้เป็นสิ่งจำเป็นเพื่อให้เนื้อหาบนเว็บไซต์ของคุณปลอดภัย และเพื่อให้แน่ใจว่าการปฏิบัติของคุณมีจริยธรรมเมื่อเทคโนโลยีก้าวหน้าไป.

มาตรการตอบโต้การขูดข้อมูล

เพื่อป้องกันไม่ให้ระบบอัตโนมัติเก็บรวบรวมข้อมูลจากเว็บไซต์ของฉัน ฉันทำการปรับเปลี่ยนไฟล์ robots.txt เป็นประจำ การปฏิบัติอย่างรอบคอบนี้ช่วยให้ฉันสามารถกำหนดได้ว่าส่วนใดของเว็บไซต์ของฉันที่บอทเช่น GPTBot สามารถเข้าถึงได้ โดยการอัปเดตคำแนะนำเหล่านี้อย่างต่อเนื่อง ฉันปกป้องเนื้อหาของเว็บไซต์ของฉันจากการถูกดึงข้อมูลโดยไม่ได้รับอนุญาตจากเครื่องมืออัตโนมัติ.

ในการทำเช่นนี้ ฉันไม่ได้เพียงแค่ทำตามขั้นตอนทางเทคนิคเท่านั้น แต่ฉันกำลังยืนหยัดเพื่อปกป้องคุณค่าและความเป็นส่วนตัวของข้อมูลที่ฉันได้ทุ่มเทสร้างขึ้นมา ในฐานะเว็บมาสเตอร์ เราต้องระมัดระวังและดำเนินการเชิงรุกเพื่อปกป้องทรัพย์สินดิจิทัลที่ผู้ใช้ไว้วางใจ ซึ่งเป็นเส้นทางสำคัญที่ไม่ควรให้ใครเข้าถึง.

โปรดจำไว้ว่าไฟล์ robots.txt ที่ได้รับการดูแลอย่างดีเป็นชั้นป้องกันที่เรียบง่ายแต่มีประสิทธิภาพต่อความพยายามอย่างไม่หยุดยั้งของผู้ขูดข้อมูล.

อัปเดตไฟล์ Robots.txt เป็นประจำ

การรักษาความปลอดภัยของเนื้อหาเว็บไซต์ของคุณหมายถึงการตรวจสอบและอัปเดตไฟล์ robots.txt ของคุณเป็นประจำ นี่คือวิธีที่ฉันทำอย่างมีประสิทธิภาพ:

- กำหนดตารางเวลาสำหรับการอัปเดตอย่างสม่ำเสมอ.

- ใช้วิธีการที่ดีที่สุดในการระบุส่วนใดของเว็บไซต์ของคุณที่ตัวแทนผู้ใช้ (เช่น เว็บครอลเลอร์) สามารถเข้าถึงได้.

- ติดตามการพัฒนาล่าสุดของเครื่องมือการขูดข้อมูล AI เพื่อรักษาความได้เปรียบเหนือความเสี่ยงด้านความปลอดภัยที่อาจเกิดขึ้น.

- ทำการปรับเปลี่ยนเส้นทางที่ห้ามเข้าให้เหมาะสมเพื่อให้แน่ใจว่าเนื้อหาของคุณยังคงได้รับการปกป้องจากการเข้าถึงโดยไม่ได้รับอนุญาต.

ทำไมต้องอัปเดตไฟล์ Robots.txt ของคุณ?

การอัปเดตไฟล์ robots.txt ของคุณเป็นวิธีที่ง่ายแต่ทรงพลังในการปกป้องเว็บไซต์ของคุณ มันบอกเครื่องมือค้นหาและโปรแกรมรวบรวมข้อมูลเว็บอื่นๆ ว่าหน้าหรือส่วนใดของเว็บไซต์ของคุณที่ไม่ควรเข้าถึงหรือ จัดทำดัชนี. สิ่งนี้สามารถช่วยป้องกันการดึงข้อมูลที่ไม่ต้องการและเป็นส่วนหนึ่งของกลยุทธ์ที่ใหญ่กว่าในการปกป้องเนื้อหาของเว็บไซต์ของคุณ.

โปรดจำไว้ว่า เมื่อมีเว็บครอลเลอร์ประเภทใหม่ๆ เกิดขึ้น การเฝ้าระวังและปรับปรุงไฟล์ robots.txt ของคุณให้ทันสมัยอยู่เสมอเป็นสิ่งที่ชาญฉลาด ไฟล์ robots.txt ที่ได้รับการดูแลอย่างดีมีความสำคัญอย่างยิ่งต่อกลยุทธ์ความปลอดภัยโดยรวมของเว็บไซต์ของคุณ.

การใช้ไฟล์ Robots.txt อย่างมีประสิทธิภาพ

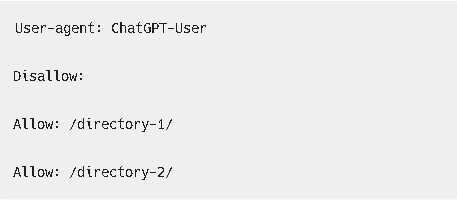

เพื่อปกป้องเว็บไซต์ของคุณจากการรวบรวมข้อมูลอัตโนมัติที่ไม่พึงประสงค์ มาพูดคุยกันถึงวิธีการอัปเดตไฟล์ robots.txt อย่างระมัดระวัง คุณสามารถกำหนดให้เว็บครอลเลอร์บางตัว เช่น GPTBot ของ OpenAI เข้าถึงหรือข้ามเนื้อหาของเว็บไซต์ของคุณได้โดยการสร้างกฎสำหรับผู้ใช้ตัวแทนเฉพาะ ด้วยการตั้งค่าพารามิเตอร์เหล่านี้อย่างละเอียด คุณจะได้รับการควบคุมอย่างแม่นยำว่าส่วนใดของเว็บไซต์ของคุณที่สามารถ จัดทำดัชนี หรือถูกมองข้ามโดยระบบ AI ที่แตกต่างกัน.

เพื่อปกป้องเว็บไซต์ของคุณจากการรวบรวมข้อมูลอัตโนมัติที่ไม่พึงประสงค์ มาพูดคุยกันถึงวิธีการอัปเดตไฟล์ robots.txt อย่างระมัดระวัง คุณสามารถกำหนดให้เว็บครอลเลอร์บางตัว เช่น GPTBot ของ OpenAI เข้าถึงหรือข้ามเนื้อหาของเว็บไซต์ของคุณได้โดยการสร้างกฎสำหรับผู้ใช้ตัวแทนเฉพาะ ด้วยการตั้งค่าพารามิเตอร์เหล่านี้อย่างละเอียด คุณจะได้รับการควบคุมอย่างแม่นยำว่าส่วนใดของเว็บไซต์ของคุณที่สามารถ จัดทำดัชนี หรือถูกมองข้ามโดยระบบ AI ที่แตกต่างกัน.

แก้ไขไฟล์ Robots.Txt อย่างถูกต้อง

เพื่อปกป้องเว็บไซต์ของคุณจากการดึงข้อมูลที่ไม่พึงประสงค์โดย AI อย่างมีประสิทธิภาพ การจัดการไฟล์ robots.txt อย่างระมัดระวังเป็นสิ่งสำคัญอย่างยิ่ง ขั้นตอนนี้เป็นพื้นฐานในการรักษาข้อมูลของเว็บไซต์ให้ปลอดภัยและเป็นไปตามกฎหมายการรวบรวมข้อมูล นี่คือคำแนะนำของฉันในการทำอย่างมีประสิทธิภาพ:

- ค้นหาไฟล์: ก่อนอื่น ฉันได้เข้าสู่ระบบเซิร์ฟเวอร์ของเว็บไซต์ของฉันและค้นหาไฟล์ robots.txt ที่มีอยู่แล้ว.

- ทบทวนกฎระเบียบปัจจุบัน: ต่อไป ฉันจะตรวจสอบไฟล์อย่างละเอียดเพื่อทำความเข้าใจกฎที่มีอยู่ทั้งหมดและผลกระทบต่อเว็บไซต์ของฉัน.

- อัปเดตด้วยความใส่ใจ: ด้วยความใส่ใจในรายละเอียด ฉันจะปรับหรือเพิ่มกฎใหม่เพื่อระบุสิ่งที่ระบบ AI สามารถทำได้และไม่สามารถทำได้ โดยใช้ ‘ห้าม:' เพื่อบล็อก และ ‘อนุญาต:' เพื่อให้สิทธิ์การเข้าถึง.

- ตรวจสอบการแก้ไข: เมื่อฉันทำการเปลี่ยนแปลงแล้ว ฉันจะรันไฟล์ robots.txt ที่อัปเดตผ่านโปรแกรมทดสอบเพื่อให้แน่ใจว่ากฎถูกเขียนอย่างถูกต้องและทำงานตามที่ตั้งใจไว้.

โดยการดำเนินการตามขั้นตอนเหล่านี้อย่างรอบคอบ ฉันอัปเดตไฟล์ robots.txt ของฉันเพื่อให้เว็บไซต์ของฉันปลอดภัยในขณะที่ยังคงต้อนรับ เครื่องมือค้นหา ที่ช่วยให้ผู้คนค้นหาเนื้อหาของฉันได้.

การนำการตรวจสอบ CAPTCHA มาใช้

เมื่อหันมาพิจารณาการตรวจสอบ CAPTCHA วิธีนี้ทำหน้าที่เป็นอุปสรรคที่แข็งแกร่งต่อการเก็บรวบรวมข้อมูลโดยอัตโนมัติโดยไม่ได้รับอนุญาต มันทำงานโดยการแยกแยะระหว่างกิจกรรมของมนุษย์จริงกับ ซอฟต์แวร์อัตโนมัติ, ซึ่งสามารถบล็อกบอทที่ไม่ต้องการได้อย่างมีประสิทธิภาพในขณะที่อนุญาตให้ผู้ใช้จริงเข้าถึงได้ อย่างไรก็ตาม เมื่อรวม CAPTCHA เข้าด้วยกัน สิ่งสำคัญคือต้องพิจารณาผลกระทบที่อาจเกิดขึ้นต่อการโต้ตอบของผู้ใช้ การหาจุดสมดุลที่เหมาะสมเป็นกุญแจสำคัญในการทำให้แน่ใจว่าเว็บไซต์ของคุณยังคงเป็นมิตรกับผู้ใช้.

ประสิทธิผลของ CAPTCHA

การรวมการตรวจสอบ CAPTCHA เป็นกลยุทธ์ที่มั่นคงในการปกป้องเว็บไซต์ของฉันจากการเข้าถึงโดยไม่ได้รับอนุญาต การขูดข้อมูล โดยเครื่องมืออัตโนมัติ นี่คือมุมมองของฉันว่าทำไมมันถึงเป็นมาตรการที่มีประสิทธิภาพ:

- ความท้าทายที่ซับซ้อน: ซับซ้อน CAPTCHA เป็นปริศนาที่ซับซ้อนซึ่งยากสำหรับระบบอัตโนมัติที่จะแก้ไข ระบบ แต่ยังสามารถจัดการได้สำหรับผู้คน.

- การอัปเดตอย่างต่อเนื่อง: โดยการปรับปรุงอัลกอริทึม CAPTCHA อย่างสม่ำเสมอ พวกเขาสามารถก้าวล้ำหน้าการพัฒนาของ AI ที่อาจหลีกเลี่ยงระบบที่ไม่เปลี่ยนแปลงได้.

- ระบบความปลอดภัยแบบหลายชั้น: เมื่อใช้ CAPTCHA ร่วมกับมาตรการรักษาความปลอดภัยอื่น ๆ จะสร้างกำแพงที่แข็งแกร่งเพื่อป้องกันการเข้าถึงโดยไม่ได้รับอนุญาต.

- ความระมัดระวัง: การติดตามประสิทธิภาพและอัตราความสำเร็จของ CAPTCHA สามารถบ่งชี้ถึงเวลาที่ควรทำการปรับเปลี่ยนหรือปรับปรุงได้.

แม้ว่าการเพิ่ม CAPTCHA จะช่วยเสริมความปลอดภัย แต่ฉันก็มักจะพิจารณาด้านจริยธรรมอยู่เสมอ และพยายามลดผลกระทบต่อผู้ใช้ให้น้อยที่สุด การหาจุดสมดุลที่เหมาะสมระหว่างความปลอดภัยที่แข็งแกร่งและการเข้าถึงของผู้ใช้เป็นงานที่ต้องทำอย่างรอบคอบและต่อเนื่อง.

ผลกระทบต่อประสบการณ์ผู้ใช้

ในขณะที่กำลังติดตั้งระบบตรวจสอบ CAPTCHA ผมตระหนักดีว่าบางครั้งอาจสร้างความรำคาญให้กับผู้ใช้ แม้ว่ามันจะช่วยหยุดบอทที่ขโมยเนื้อหาโดยใช้ AI ได้ดีก็ตาม การประเมินของผมแสดงให้เห็นว่า CAPTCHA มีประสิทธิภาพในการป้องกันไม่ให้บอทเหล่านี้เข้ามา ซึ่งช่วยจัดการการไหลของผู้เยี่ยมชมเว็บไซต์และลดโอกาสที่เนื้อหาจะถูกคัดลอกโดยไม่ได้รับอนุญาต อย่างไรก็ตาม การใช้เครื่องมือนี้อย่างชาญฉลาดเป็นสิ่งสำคัญเพื่อป้องกันไม่ให้ผู้ที่เยี่ยมชมเว็บไซต์ของคุณรู้สึกไม่พอใจและจากไป ทั้งหมดนี้คือการหาสมดุลที่เหมาะสมระหว่างการทำให้เนื้อหาของคุณเข้าถึงได้ง่ายและการปกป้องมันจากการขูดข้อมูลที่ไม่พึงประสงค์โดย AI การทดสอบ CAPTCHA มากเกินไปอาจทำให้ผู้ใช้จริงจำนวนเท่าๆ กับบอทหนีไปได้ ฉันใช้ CAPTCHA ในพื้นที่ที่มีโอกาสเกิดการขูดข้อมูลมากที่สุด ในขณะที่ยังคงรักษาส่วนที่เหลือของเว็บไซต์ให้ใช้งานง่าย เป้าหมายของฉันคือการมอบประสบการณ์ที่ยอดเยี่ยมให้กับผู้เยี่ยมชมเว็บไซต์ ในขณะเดียวกันก็รักษาความปลอดภัยของเนื้อหาเว็บไซต์จากการขูดข้อมูลโดยไม่ได้รับอนุญาตจาก AI.

การบล็อกครอลเลอร์ AI เฉพาะเจาะจง

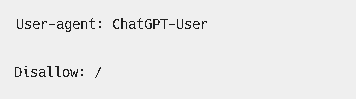

ในฐานะผู้ดูแลเว็บไซต์ ฉันมีความสามารถในการบล็อกเครื่องมือค้นหาของ AI บางตัว เช่น GPTBot ของ OpenAI เพื่อหยุดไม่ให้พวกมันคัดลอกเนื้อหาจากเว็บไซต์ของฉัน ขั้นตอนนี้ไม่เพียงแต่เกี่ยวกับการหยุดการรวบรวมเนื้อหาโดยไม่ได้รับอนุญาต แต่ยังเกี่ยวกับการเคารพมาตรฐานทางจริยธรรมและกฎระเบียบทางกฎหมายเกี่ยวกับการใช้เนื้อหาด้วย นี่คือวิธีที่ฉันดำเนินการ:

- แก้ไข

ไฟล์โรบ็อตส์ทีทีเอ็กซ์: ฉันปรับไฟล์นี้ด้วยคำแนะนำเฉพาะสำหรับโปรแกรมรวบรวมข้อมูล AI โดยระบุส่วนต่างๆ ของเว็บไซต์ที่ไม่อนุญาตให้เข้าถึง.

ผู้ใช้เอเจนต์: GPTBot

ไม่อนุญาต: /

ผู้ใช้: ChatGPT-User

ไม่อนุญาต: /

ผู้ใช้เอเจนต์: CCBot

ไม่อนุญาต: /

- ตรวจสอบบันทึกเซิร์ฟเวอร์: ฉันทำให้การตรวจสอบบันทึกของเซิร์ฟเวอร์เป็นส่วนหนึ่งของกิจวัตรประจำวัน เพื่อค้นหาความเคลื่อนไหวของโปรแกรมรวบรวมข้อมูล AI ที่ดูผิดปกติ.

- ตั้งค่า CAPTCHA: ในส่วนของเว็บไซต์ของฉันที่ผู้ใช้มีปฏิสัมพันธ์ ฉันใช้ CAPTCHA การทดสอบเหล่านี้มีประสิทธิภาพมากในการแยกแยะระหว่างคนจริงกับบอทอัตโนมัติ.

- บล็อกที่อยู่ IP บางรายการ: เมื่อฉันต้องการ ฉันจะบล็อกที่อยู่ IP ที่ฉันรู้ว่าเชื่อมโยงกับโปรแกรมรวบรวมข้อมูล AI เพื่อป้องกันไม่ให้พวกมันเข้ามาในเว็บไซต์ของฉัน.

โดยการกระทำสิ่งเหล่านี้ ฉันปกป้องเนื้อหาของฉัน และทำให้แน่ใจว่าฉันปฏิบัติตามกฎที่เกี่ยวข้องกับความเป็นส่วนตัวของข้อมูลและทรัพย์สินทางปัญญา.

การจัดการการเข้าถึงเนื้อหา

ปกป้องเนื้อหาเว็บไซต์ของคุณจากการขูดข้อมูลโดยไม่ได้รับอนุญาต

เพื่อแก้ไขปัญหาการขโมยเนื้อหา ขอให้เราหารือเกี่ยวกับวิธีการที่มีประสิทธิภาพในการควบคุมว่าใครสามารถเข้าถึงเนื้อหาของเว็บไซต์คุณได้บ้าง การจำกัดการเข้าถึงของบอทเป็นสิ่งสำคัญอย่างยิ่ง และฉันจะอธิบายเทคนิคเฉพาะเพื่อป้องกันไม่ให้ระบบอัตโนมัติเหล่านี้คัดลอกหรือ การจัดทำดัชนี วัสดุในเว็บไซต์ของคุณ ซึ่งจะต้องมีการเปลี่ยนแปลงทางเทคนิคและการตั้งค่ามาตรการควบคุมการเข้าถึงอย่างรอบคอบ.

ปกป้องเนื้อหาเว็บไซต์ของคุณ

สำหรับผู้ที่ดูแลเว็บไซต์ การทำให้แน่ใจว่าเนื้อหาของคุณยังคงเป็นเอกสิทธิ์และได้รับการปกป้องจากระบบดึงข้อมูลอัตโนมัติเป็นความกังวลที่สำคัญ การนำมาตรการทางเทคนิคเฉพาะมาใช้สามารถช่วยคุณควบคุมว่าใครมีความสามารถในการเข้าถึงและ ดัชนี เนื้อหาของเว็บไซต์ของคุณ.

คุณอาจพิจารณาปรับแต่งไฟล์ robots.txt ของคุณ ไฟล์เพื่อสั่งการเครื่องมือค้นหา ส่วนใดของเว็บไซต์ของคุณที่ไม่ควรให้บอทเข้าถึง การใช้ระบบ CAPTCHA ยังสามารถช่วยป้องกันบอทได้โดยไม่รบกวนผู้ใช้ที่เป็นมนุษย์ สำหรับวิธีการที่ซับซ้อนมากขึ้น คุณอาจใช้การตรวจสอบฝั่งเซิร์ฟเวอร์เพื่อแยกแยะระหว่างผู้เข้าชมที่ถูกต้องกับผู้ที่อาจเข้ามาขูดข้อมูล.

โปรดจำไว้ว่าความซื่อสัตย์และความเป็นเอกสิทธิ์ของเนื้อหาของคุณเป็นสิ่งสำคัญที่สุด การดำเนินการเชิงรุกเพื่อรักษาความปลอดภัยของเว็บไซต์ของคุณจะช่วยให้คุณควบคุมเนื้อหาและการเผยแพร่ได้อย่างเต็มที่ ท้ายที่สุดแล้ว เนื้อหาที่คุณสร้างขึ้นเป็นภาพสะท้อนของแบรนด์ของคุณและควรได้รับการปกป้องอย่างระมัดระวัง.

การจำกัดการเข้าถึงของบอท

การจำกัดการเข้าถึงของบอท

ฉันได้ค้นพบว่า การทำตามขั้นตอนที่เฉพาะเจาะจงสามารถลดความเสี่ยงของระบบอัตโนมัติที่เก็บรวบรวมเนื้อหาจากเว็บไซต์ของฉันได้อย่างมาก นี่คือวิธีที่ฉันทำ:

- การปรับแต่งไฟล์ Robots.txt: ฉันปรับแต่ง

ไฟล์โรบ็อตส์ทีทีเอ็กซ์ไฟล์เพื่อควบคุมการเข้าถึงของบอท โดยคำนึงถึงข้อกฎหมายที่เกี่ยวข้องกับการดึงข้อมูลและการคุ้มครองความเป็นส่วนตัวของข้อมูล. - การกำหนดขีดจำกัดอัตรา: โดยการกำหนดขีดจำกัดความเร็วบนเซิร์ฟเวอร์ของฉัน ฉันสามารถลดผลกระทบที่อาจเกิดขึ้นจากการจราจรของบอทได้.

- การนำไปใช้ของระบบควบคุม API: ฉันแบ่งปันข้อมูลน้อยที่สุดเท่าที่จำเป็นผ่าน API และต้องการการยืนยันตัวตนที่เหมาะสมเพื่อจำกัดการเข้าถึง.

- การใช้เครือข่ายการส่งมอบเนื้อหา: การใช้ CDN ที่มีคุณสมบัติการจัดการบอทช่วยให้ฉันสามารถจัดการผู้ที่เข้าถึงเนื้อหาของฉันและปกป้องมันได้อย่างมีประสิทธิภาพ.

การดำเนินการตามขั้นตอนเหล่านี้จะสร้างแนวป้องกันที่แข็งแกร่งต่อการเก็บรวบรวมเนื้อหาโดยไม่ได้รับอนุญาตโดยเครื่องมืออัตโนมัติ.

การป้องกันการขโมยเนื้อหา

หลังจากอัปเดตของฉัน ไฟล์โรบ็อตส์ทีทีเอ็กซ์ ไฟล์, ตอนนี้ฉันกำลังมุ่งเน้นไปที่มาตรการป้องกันการขูดข้อมูล (content scraping) เพื่อให้แน่ใจว่าเว็บไซต์ของฉันยังคงสามารถเข้าถึงได้และปลอดภัย. ฉันกำลังตรวจสอบแง่มุมทางเทคนิคของการขูดข้อมูล, ผลกระทบทางกฎหมาย, และความสำคัญของการปกป้องข้อมูลผู้ใช้จากวิธีการขูดข้อมูลด้วยปัญญาประดิษฐ์ที่ซับซ้อน.

| กลยุทธ์ | คำอธิบาย |

|---|---|

| การส่งมอบเนื้อหาแบบปรับเปลี่ยนได้ | ให้เนื้อหาที่แตกต่างกันแก่เครื่องมืออัตโนมัติกับผู้เยี่ยมชมที่เป็นมนุษย์. |

| การตรวจสอบกิจกรรมของผู้ใช้ | ตรวจสอบพฤติกรรมที่อาจบ่งชี้ถึงการขูดข้อมูล. |

| ข้อจำกัดการเข้าถึง | ควบคุมความถี่ที่ผู้ใช้สามารถเข้าถึงเนื้อหาและบล็อกที่อยู่ IP ที่น่าสงสัย. |

โดยการนำกลยุทธ์เหล่านี้มาใช้อย่างรอบคอบ ฉันไม่ได้เพียงแค่ปกป้องเนื้อหาของเว็บไซต์ของฉันเท่านั้น แต่ยังรักษาข้อมูลของผู้ใช้ให้เป็นส่วนตัวและปลอดภัยอีกด้วย นี่คือแผนที่ตั้งใจไว้เพื่อจัดการเนื้อหาของเว็บไซต์ของฉัน และป้องกันการเข้าถึงหรือการใช้งานที่ไม่ได้รับอนุญาตจากเครื่องมืออัตโนมัติ.

การนำกลยุทธ์เหล่านี้มาใช้เป็นวิธีที่ชาญฉลาดในการก้าวล้ำหน้าผู้ที่อาจพยายามใช้ประโยชน์จากความพยายามของคุณในทางที่ผิด เปรียบเสมือนการติดตั้งระบบเตือนภัยที่ทันสมัยซึ่งไม่เพียงแต่เฝ้าระวังผู้บุกรุกเท่านั้น แต่ยังเคารพความเป็นส่วนตัวของแขกของคุณด้วย เป็นเรื่องของการป้องกันเชิงรุกมากกว่าการแก้ไขปัญหาเมื่อเผชิญกับภัยคุกคามที่อาจเกิดขึ้น.

การปรับปรุงมาตรการรักษาความปลอดภัยอย่างสม่ำเสมอ

การตั้งค่าการป้องกันเบื้องต้น เช่น การปรับแต่งไฟล์ robots.txt หรือเพิ่ม CAPTCHA เป็นจุดเริ่มต้นที่ดี แต่เพื่อปกป้องเว็บไซต์ของคุณจากเครื่องมือ AI ขั้นสูงที่ดึงข้อมูลเนื้อหาอย่างมีประสิทธิภาพ จำเป็นต้องปรับปรุงกลยุทธ์ด้านความปลอดภัยของเว็บไซต์อย่างต่อเนื่อง สภาพแวดล้อมทางเทคโนโลยีเปลี่ยนแปลงอยู่ตลอดเวลา ความสามารถของ AI ก็พัฒนาขึ้นเรื่อย ๆ และบางครั้งก็สามารถหลุดรอดจากวิธีการรักษาความปลอดภัยแบบเดิม ๆ ได้ ดังนั้น การรักษาความปลอดภัยของเว็บไซต์จึงต้องอาศัยแนวทางที่มีกลยุทธ์ เชี่ยวชาญด้านเทคโนโลยี และเป็นระบบ.

นี่คือกลยุทธ์ของฉัน:

- การทบทวนความปลอดภัยตามปกติ: ฉันให้ความสำคัญกับการตรวจสอบความปลอดภัยอย่างสม่ำเสมอ เพื่อค้นหาจุดอ่อนที่อาจเกิดขึ้นใหม่ และเพื่อให้มั่นใจว่ามาตรการป้องกันของฉันทันสมัยและมีประสิทธิภาพอยู่เสมอ.

- ติดตามการอัปเดตอยู่เสมอ: ฉันติดตามข่าวสารเกี่ยวกับแพตช์ความปลอดภัยล่าสุดอยู่เสมอ และตรวจสอบให้แน่ใจว่าองค์ประกอบซอฟต์แวร์ทั้งหมดของเว็บไซต์ของฉันเป็นเวอร์ชันล่าสุด.

- การปรับมาตรการรักษาความปลอดภัย: ฉันปรับการตั้งค่าความปลอดภัยของฉันเพื่อจัดการกับภัยคุกคามเฉพาะ ซึ่งช่วยให้เกิดความสมดุลที่ดีระหว่างการปกป้องเนื้อหาและการทำให้สามารถเข้าถึงได้ด้วยเหตุผลที่ถูกต้อง.

- การวิเคราะห์และรายงานการจราจร: โดยการติดตามการไหลของทราฟฟิกมายังเว็บไซต์ของฉันและตรวจสอบบันทึกการเข้าถึงอย่างละเอียด ฉันสามารถระบุและดำเนินการกับพฤติกรรมที่น่าสงสัยที่อาจบ่งชี้ถึงความพยายามในการขูดข้อมูลด้วย AI ได้อย่างรวดเร็ว.

การรักษาความปลอดภัยเว็บไซต์ของฉันไม่ใช่เรื่องที่ทำครั้งเดียวแล้วจบ แต่เป็นความท้าทายที่ต้องทำอย่างต่อเนื่องเพื่อป้องกันผู้ที่มีเจตนาร้าย ด้วยการเฝ้าระวังและดำเนินการเชิงรุกเกี่ยวกับความปลอดภัย ฉันไม่ได้ปกป้องเพียงแค่เนื้อหาของเว็บไซต์เท่านั้น แต่ยังรวมถึงความเป็นส่วนตัวของผู้ที่เข้าชมด้วย.

การสำรวจการคุ้มครองทางกฎหมาย

ในการนำทางผ่านความซับซ้อนทางกฎหมาย ฉันกำลังตรวจสอบกฎหมายและข้อบังคับเกี่ยวกับลิขสิทธิ์เพื่อป้องกันการขูดข้อมูลโดย AI ที่ไม่ได้รับอนุญาต เพื่อปกป้องเว็บไซต์ของฉัน สิ่งสำคัญคือต้องใช้วิธีการที่เป็นระบบเพื่อทำความเข้าใจว่ากฎหมายลิขสิทธิ์ทั้งในระดับประเทศและระหว่างประเทศมีผลกระทบต่อเนื้อหาบนเว็บไซต์ของฉันอย่างไร นอกจากนี้ ฉันยังได้ทบทวนพระราชบัญญัติลิขสิทธิ์ดิจิทัลสหัสวรรษ (DMCA) เพื่อดูว่ามันสามารถปกป้องเนื้อหาของฉันจากการละเมิดโดย AI ได้อย่างไร.

การประเมินเงื่อนไขการใช้งานเครื่องมือ AI เป็นขั้นตอนที่รับผิดชอบเพื่อให้แน่ใจว่าเครื่องมือเหล่านี้ไม่ละเมิดสิทธิ์ในการใช้และรวบรวมข้อมูลจากเว็บไซต์ การให้ความสนใจในรายละเอียดนี้มีความสำคัญอย่างยิ่งต่อการรักษาประสบการณ์การใช้งานของเว็บไซต์ของฉัน และป้องกันการนำเนื้อหาของฉันไปใช้ในทางที่ผิด ซึ่งอาจทำให้ผลกระทบของแบรนด์ของฉันลดลง และทำให้การมีส่วนร่วมของผู้เข้าชมน้อยลง.

นอกจากนี้ ฉันกำลังพิจารณาใช้กลยุทธ์ทางเทคนิค เช่น การนำการควบคุมการเข้าถึงที่เข้มงวดมาใช้ และการวิเคราะห์การจราจรอย่างต่อเนื่องเพื่อระบุและลดความพยายามในการขูดข้อมูล การผสมผสานระหว่างมาตรการทางกฎหมายและการป้องกันทางเทคนิคเป็นแผนของฉันในการรักษาความเป็นเอกลักษณ์ของเว็บไซต์และปกป้องความพยายามสร้างสรรค์ที่อยู่เบื้องหลัง.

คำถามที่พบบ่อย

หากฉันบล็อกเครื่องมือ AI จากการดึงข้อมูลจากเว็บไซต์ของฉัน จะส่งผลต่อความมองเห็นหรือการจัดอันดับของเว็บไซต์ของฉันบนเครื่องมือค้นหาอื่น ๆ เช่น Google หรือ Bing หรือไม่?

ฉันกำลังพิจารณาว่าการป้องกันไม่ให้เครื่องมือ AI ดึงข้อมูลจากเว็บไซต์ของฉันอาจส่งผลต่อประสิทธิภาพของเว็บไซต์ของฉันบน เครื่องมือค้นหา เช่น Google หรือ Bing. สิ่งสำคัญคือต้องเคลียร์ความสับสนเกี่ยวกับการมองเห็นออนไลน์; สิ่งเหล่านี้ เครื่องมือค้นหาใช้ขั้นตอนวิธีที่ไม่ซ้ำกันในการจัดอันดับ. พวกเขาไม่ได้พึ่งพาแต่เพียงอย่างเดียว การจัดทำดัชนี โดยเครื่องมือ AI เป้าหมายของฉันคือการปกป้องเนื้อหาของฉันและยังคงรักษาตำแหน่งที่ดีใน ผลการค้นหา. ในทางปฏิบัติ นี่หมายถึงการหาสมดุลอย่างรอบคอบระหว่างการปกป้อง เนื้อหาของเว็บไซต์และการบรรลุ SEO ที่มั่นคง ผลลัพธ์.

ฉันจะแยกแยะระหว่างโปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาที่ถูกต้องกับโปรแกรมรวบรวมข้อมูลของ AI ได้อย่างไรเมื่อวิเคราะห์การเข้าชมเว็บไซต์ของฉัน?

เพื่อแยกแยะระหว่างโปรแกรมรวบรวมข้อมูลของเครื่องมือค้นหาที่ถูกต้องตามกฎหมายกับโปรแกรมรวบรวมข้อมูล AI ที่ไม่ได้รับอนุญาตเมื่อดูที่ ปริมาณการเข้าชมเว็บไซต์, ฉันตรวจสอบรูปแบบพฤติกรรมของผู้ใช้อย่างใกล้ชิดที่อาจบ่งชี้ถึงการโต้ตอบอัตโนมัติ เพื่อป้องกันทราฟฟิกที่อาจเป็นอันตราย ฉันใช้เทคนิคการบล็อก IP นอกจากนี้ ฉันยังใช้ประโยชน์จากเครื่องมือตรวจจับบอท ซึ่งช่วยฉันระบุและควบคุมบอทที่ไม่ได้รับอนุญาต มาตรการเหล่านี้ช่วยปกป้องเนื้อหาของฉันในขณะที่ทำให้แน่ใจว่าเว็บไซต์ของฉันยังคงเข้าถึงได้สำหรับผู้ใช้ที่น่าเชื่อถือ เครื่องมือค้นหา.

การเข้าใจความแตกต่างระหว่างทราฟฟิกที่แท้จริงกับทราฟฟิกเทียมช่วยให้การวิเคราะห์เว็บไซต์ของฉันยังคงถูกต้อง และเนื้อหาของฉันไม่ตกไปอยู่ในมือที่ไม่เหมาะสม ในฐานะเจ้าของเว็บไซต์ ฉันมีความรับผิดชอบที่จะต้องรักษาความปลอดภัยให้กับทรัพย์สินดิจิทัลของฉัน เช่นเดียวกับที่เจ้าของร้านค้าปกป้องร้านค้าจากโจรขโมย ด้วยกลยุทธ์เหล่านี้ ฉันสามารถบริหารจัดการทราฟฟิกของเว็บไซต์ได้อย่างมั่นใจและรักษาความสมบูรณ์ของเว็บไซต์ไว้ได้.

หากฉันสังเกตเห็นว่าเนื้อหาของฉันถูกคัดลอกโดยเครื่องมือ AI โดยไม่ได้รับอนุญาตจากฉัน ฉันควรทำอย่างไร?

เมื่อพบว่าเนื้อหาของฉันถูกนำไปใช้โดยเครื่องมือ AI โดยไม่ได้รับความยินยอมจากฉัน ขั้นตอนแรกคือการบันทึกทุกกรณีของการละเมิดนี้อย่างละเอียดถี่ถ้วน ต่อไป ฉันจะพยายามเรียกคืนเนื้อหาของฉันโดยติดต่อฝ่ายที่รับผิดชอบ หรือหากจำเป็น จะออกคำร้องขอให้ลบเนื้อหาตามกฎหมาย DMCA หากมาตรการเหล่านี้ไม่สามารถแก้ไขปัญหาได้ การพิจารณาดำเนินการทางกฎหมายก็เป็นทางเลือกหนึ่ง นอกจากนี้ การแจ้งให้สาธารณชนทราบเกี่ยวกับการใช้งานผลงานของฉันโดยไม่ได้รับอนุญาตก็เป็นประโยชน์ เพื่อส่งเสริมการใช้เครื่องมือ AI อย่างมีจริยธรรม การเฝ้าระวังและการดำเนินการอย่างรวดเร็วเป็นสิ่งสำคัญในการปกป้องสิทธิ์ในผลงานสร้างสรรค์ของตนบนโลกออนไลน์.

จำไว้: การปกป้องผลงานสร้างสรรค์ของคุณไม่ใช่แค่สิทธิ แต่เป็นความรับผิดชอบ.

มีมาตรฐานอุตสาหกรรมหรือแนวทางปฏิบัติที่ดีที่สุดสำหรับการใส่ลายน้ำในเนื้อหาของฉันเพื่อระบุว่าไม่ควรนำไปใช้สำหรับการฝึกอบรมโมเดล AI หรือไม่?

ขณะนี้ฉันกำลังทบทวนวิธีการปกป้องเนื้อหาของฉันจากการใช้งานโดยไม่ได้รับอนุญาตในการฝึกอบรมโมเดล AI แนวทางหนึ่งคือการใช้ลายน้ำดิจิทัลและการทำลายนิ้วมือเนื้อหา ซึ่งเป็นการแทรกเครื่องหมายที่มองไม่เห็นหรือรหัสเฉพาะเข้าไปในงานของฉัน เมื่อใช้ร่วมกับนโยบายที่ชัดเจนเกี่ยวกับการใช้งาน กลยุทธ์เหล่านี้ทำหน้าที่เป็นสัญญาณว่าวัสดุของฉันไม่ควรถูกนำไปใช้ฝึกฝนโมเดล AI ชุมชนยังคงทำงานเพื่อสร้างชุดแนวทางปฏิบัติที่เป็นมาตรฐานในเรื่องนี้ ดังนั้นฉันจึงติดตามข้อมูลเกี่ยวกับกลยุทธ์ล่าสุดเพื่อให้แน่ใจว่างานของฉันได้รับการปกป้องอย่างเหมาะสม.

“การคุ้มครองทรัพย์สินทางปัญญาในยุคที่ข้อมูลถูกป้อนเข้าสู่ระบบอัลกอริทึมอย่างต่อเนื่องเป็นความกังวลร่วมกันของผู้สร้างสรรค์. การมีทัศนคติที่รอบคอบและมีการเตรียมตัวไว้ล่วงหน้าเป็นสิ่งที่ดี.”

หากเครื่องมือ AI สามารถพัฒนาความสามารถในการผ่าน CAPTCHA ได้ ฉันจำเป็นต้องนำกลยุทธ์การรักษาความปลอดภัยที่ซับซ้อนมากขึ้นมาใช้เพื่อปกป้องเว็บไซต์ของฉันจากการดึงข้อมูลโดยไม่ได้รับอนุญาต หนึ่งในวิธีที่มีประสิทธิภาพคือ ชีวมาตรพฤติกรรม, ซึ่งตรวจสอบความผิดปกติในการที่ผู้ใช้โต้ตอบกับเว็บไซต์ ซึ่งสามารถช่วยแยกแยะระหว่างผู้เยี่ยมชมที่เป็นมนุษย์กับผู้รวบรวมข้อมูลอัตโนมัติที่อาจเกิดขึ้นได้.

อีกชั้นหนึ่งของการป้องกันเกี่ยวข้องกับ การวิเคราะห์ลายนิ้วมือ. เทคนิคนี้ประเมินคุณลักษณะเฉพาะของอุปกรณ์และเบราว์เซอร์ เช่น ระบบปฏิบัติการ ความละเอียดหน้าจอ และฟอนต์ที่ติดตั้ง เพื่อตรวจจับความไม่สอดคล้องกันที่มักพบในกิจกรรมของบอท.

เพื่อให้ก้าวนำหน้าหนึ่งก้าว ฉันจะลงมือทำ ความท้าทายที่ปรับตัวได้. สิ่งเหล่านี้คือการตรวจสอบความปลอดภัยที่อาจมีความซับซ้อนแตกต่างกันไปตามความเสี่ยงที่ประเมินไว้ ซึ่งช่วยให้การป้องกันมีความยืดหยุ่นและปรับตัวตามระดับของภัยคุกคามที่ตรวจพบได้. ด้วยการใช้วิธีการขั้นสูงเหล่านี้ ฉันสามารถเสริมความปลอดภัยของเว็บไซต์ของฉันได้อย่างมีนัยสำคัญต่อเครื่องมือการขูดข้อมูลที่ใช้ปัญญาประดิษฐ์ล่าสุด.

การป้องกันการขูดข้อมูลด้วย AI คืออะไรในบริบทของเวิลด์ไวด์เว็บ?

การป้องกันการขูดข้อมูลด้วย AI หมายถึงวิธีการและเทคโนโลยีที่ใช้เพื่อป้องกันไม่ให้บอทอัตโนมัติทำการเก็บรวบรวมหรือขูดข้อมูลจากเว็บไซต์โดยไม่ได้รับอนุญาต เทคโนโลยีเหล่านี้ใช้ความสามารถของปัญญาประดิษฐ์เพื่อตรวจจับ ระบุ และบล็อกกิจกรรมดังกล่าว.

ทำไมโปรแกรมรวบรวมข้อมูลด้วยปัญญาประดิษฐ์จึงเป็นภัยคุกคามต่อทรัพย์สินทางปัญญาบนอินเทอร์เน็ต?

โปรแกรมขูดข้อมูลด้วย AI เป็นภัยคุกคามเนื่องจากสามารถรวบรวมข้อมูลที่เป็นกรรมสิทธิ์จำนวนมากที่เผยแพร่บนเว็บได้อย่างรวดเร็วและมีประสิทธิภาพ ข้อมูลนี้อาจรวมถึงเนื้อหาที่มีลิขสิทธิ์ ความลับทางการค้า ฐานข้อมูล หรือทรัพย์สินดิจิทัลอื่นๆ ที่มีไว้เพื่อการใช้งานบนเว็บไซต์ต้นทางเท่านั้น.

เครื่องมือดึงข้อมูลด้วย AI ทำงานอย่างไร?

เครื่องมือสกัดข้อมูลด้วย AI ทำงานโดยการจำลองพฤติกรรมการท่องเว็บของมนุษย์ มันเข้าชมหน้าเว็บ ระบุข้อมูลที่เกี่ยวข้องตามเกณฑ์ที่กำหนดไว้ล่วงหน้า จากนั้นดึงข้อมูลนี้ไปใช้ในที่อื่น ความซับซ้อนของเครื่องมือเหล่านี้แตกต่างกันอย่างมาก บางเครื่องมือสามารถนำทางโครงสร้างเว็บไซต์ที่ซับซ้อนและหลบเลี่ยงมาตรการป้องกันการสกัดข้อมูลขั้นพื้นฐานได้.

เทคนิคใดบ้างที่มักใช้ในการป้องกันการขูดข้อมูลด้วย AI?

เทคนิคที่มักใช้ในป้องกันการขูดข้อมูลด้วย AI ได้แก่ การจำกัดอัตรา (การจำกัดจำนวนคำขอที่ที่อยู่ IP สามารถทำได้ภายในระยะเวลาที่กำหนด), การทดสอบ CAPTCHA (ซึ่งท้าทายผู้ใช้ให้พิสูจน์ว่าพวกเขาเป็นมนุษย์), การวิเคราะห์ตัวแทนผู้ใช้ (เพื่อระบุกิจกรรมของเบราว์เซอร์ที่น่าสงสัย), และอัลกอริธึมการเรียนรู้ของเครื่องขั้นสูงที่สามารถตรวจจับรูปแบบผิดปกติที่บ่งชี้ถึงพฤติกรรมของบอท.

ปัญญาประดิษฐ์สามารถนำมาใช้เพื่อป้องกันการกระทำของการขูดข้อมูลทางเว็บได้หรือไม่?

ใช่, รูปแบบต่าง ๆ ของปัญญาประดิษฐ์ เช่น อัลกอริทึมการเรียนรู้ของเครื่อง สามารถนำมาใช้เพื่อตรวจจับและป้องกันการขูดข้อมูลจากเว็บไซต์ได้ ระบบเหล่านี้เรียนรู้จากกรณีพฤติกรรมของบอทในอดีต ทำให้สามารถคาดการณ์และป้องกันการโจมตีที่อาจเกิดขึ้นในอนาคตได้ดีขึ้น พวกมันอาจใช้เทคนิคการตรวจจับแบบเรียลไทม์ซึ่งช่วยให้สามารถดำเนินการได้ทันทีเมื่อมีการสงสัยว่ามีการกระทำของบอทเกิดขึ้น.

ข้อคิดสุดท้ายของฉันเกี่ยวกับการปกป้องเว็บไซต์ของคุณจากการถูกเครื่องมือ AI ขูดข้อมูล

การรักษาความปลอดภัยเว็บไซต์ของฉันจากการขูดข้อมูลโดย AI ที่ไม่ต้องการเป็นความพยายามอย่างต่อเนื่องที่ต้องการความรอบคอบ ฉันพบว่าการใช้ robots.txt อย่างชาญฉลาด การนำ CAPTCHA มาใช้ การบล็อกโปรแกรมรวบรวมข้อมูล AI ที่รู้จัก การจัดการการเข้าถึงเนื้อหา และการอัปเดตมาตรการรักษาความปลอดภัยอย่างสม่ำเสมอ เป็นขั้นตอนที่สำคัญมาก แม้ว่าการเพิ่มมาตรการทางกฎหมายจะช่วยเพิ่มการป้องกันอีกชั้นหนึ่ง แต่การเฝ้าระวังและมีความเชี่ยวชาญทางเทคนิคอย่างต่อเนื่องเป็นกุญแจสำคัญในการทำให้แน่ใจว่าเนื้อหาของฉันยังคงอยู่ภายใต้การควบคุมของฉัน จึงรักษาความสมบูรณ์ของเว็บไซต์และคุณค่าที่มอบให้กับผู้ที่เข้าชม.

เอกสารอ้างอิงที่น่าเชื่อถือ

หากคุณต้องการอ่านเพิ่มเติมเกี่ยวกับการปกป้องเว็บไซต์ของคุณจาก AI Crawlers ฉันขอแนะนำให้คุณดูโพสต์ต่อไปนี้:

- ITPro – การดึงข้อมูลจากเว็บไซต์ด้วย AI: วิธีปกป้องธุรกิจของคุณจาก

- บทความนี้กล่าวถึงความซับซ้อนของการดึงข้อมูลจากเว็บไซต์ด้วยปัญญาประดิษฐ์ (AI web scraping) และความเสี่ยงที่เกี่ยวข้อง โดยให้ข้อมูลเชิงลึกเกี่ยวกับวิธีที่ AI สามารถรวบรวมข้อมูลได้ด้วยความรวดเร็วและความซับซ้อนที่มากขึ้น รวมถึงการวิเคราะห์ข้อมูลเพื่อสร้างผลลัพธ์ที่ต้องการ.

- บทความ ITPro

- สมาคมนักเขียน – เคล็ดลับปฏิบัติสำหรับนักเขียนในการปกป้องผลงานจากการใช้งาน AI

- แหล่งข้อมูลนี้ให้คำแนะนำที่เป็นประโยชน์สำหรับผู้เขียนและเจ้าของเว็บไซต์เกี่ยวกับวิธีการปกป้องผลงานของตนจากการใช้งาน AI รวมถึงการใช้ไฟล์ robots.txt เพื่อบล็อกเว็บครอลเลอร์ AI เช่น GPTBot ของ OpenAI.

- คำแนะนำจากสมาคมนักเขียน

- Resolution Digital – ปกป้องเว็บไซต์จาก เนื้อหา AI การดึงข้อมูล

- บทความนี้นำเสนอขั้นตอนง่ายๆ เพื่อปกป้องเว็บไซต์ของคุณจากการขูดข้อมูลและการใช้งานโดยไม่ได้รับอนุญาตจากเครื่องมือ AI เช่น ChatGPT โดยจะกล่าวถึงการใช้ไฟล์ robots.txt การติดตั้ง CAPTCHA และการบล็อกช่วง IP.

- คู่มือดิจิทัลสำหรับ Resolution

- Octoparse – การดึงข้อมูลจากเว็บไซต์เพื่อการปกป้องแบรนด์และความปลอดภัยทางไซเบอร์

- สิ่งนี้ บล็อก โพสต์นี้สำรวจวิธีการใช้เว็บสเครปปิ้งเพื่อการปกป้องแบรนด์และความปลอดภัยทางไซเบอร์ โดยกล่าวถึงการใช้เครื่องมือเว็บสเครปปิ้งเพื่อค้นหาการละเมิดที่อาจเกิดขึ้นและการละเมิดลิขสิทธิ์.

- Octoparse บทความ

- ScienceDirect – สงครามต่อต้านการขูดข้อมูลเว็บด้วย AI

- บทความนี้จาก ScienceDirect สำรวจการคัดค้านที่เพิ่มขึ้นต่อการดึงข้อมูลจากเว็บไซต์ด้วย AI โดยเน้นถึงความก้าวหน้าอย่างรวดเร็วของ AI และการฝึกฝนบนชุดข้อมูลขนาดใหญ่ของข้อความและเนื้อหาดิจิทัลอื่นๆ.

- บทความจาก ScienceDirect